Цей матеріал є частиною серії PROMPT.

Повторні президентські вибори в Румунії, скасовані торік через підозри у зовнішньому втручанні, й цього разу залишаються у тіні побоювань щодо кібератак, прихованих зв’язків і скоординованих інформаційних кампаній. У першому турі кандидат від ультраправих сил Джордж Сіміон набрав 40,96% голосів.

Рецензію до статті надала Ралука Раду, Бухарестський університет.

Аналіз даних здійснили Фабіо Гільєтто та Массімо Теренці, Університет Урбіно.

У 2024 році президентські вибори в Румунії були анульовані через підозри у втручанні іноземних держав. Британський аналітичний центр Foreign Policy Centre (FPC) у своєму звіті представив переконливі докази скоординованої онлайн-активності, пов’язаної з російськими інформаційними кампаніями. Зокрема, з використанням системи штучного інтелекту «Osavul» було проаналізовано понад 3500 повідомлень, поширених під час анульованих виборів на таких платформах, як Telegram, Facebook, X (колишній Twitter) та YouTube (Martinescu et al., 2024). Результати свідчать: більшість ворожого контенту походила з Росії або була створена пов’язаними з нею структурами, зокрема державними медіа RT і Sputnik. На цьогорічних повторних виборах, як показують нові дані проєкту PROMPT, скоординована поведінка в онлайн-середовищі не припинилась. Вона сприяла мобілізації радикальних настроїв, що дозволило ультраправому кандидату Джорджу Сіміону здобути рекордну підтримку у першому турі 4 травня 2025 року — 40,96% голосів.

Що сталося на нових виборах? Виявлено координацію та астротурфінг

У межах проєкту PROMPT дослідники Урбінського університету проаналізували 45 272 публікації у Facebook з 1454 акаунтів у період з 17 по 24 квітня 2025 року. Аналіз, здійснений із використанням великих мовних моделей (LLM), базувався на списках акторів, підготовлених волонтерською мережею AI de noi. Ця спільнота займається моніторингом порушень — таких як фейкові акаунти, згенеровані штучним інтелектом зображення та маніпуляції емоційним контентом.

Результати показали: більшість публікацій віддавали перевагу емоційно зарядженому контенту та клікбейту замість фактологічної інформації. Значна частина містила штучно згенеровані зображення й зосереджувалася на темах трагічних особистих історій, новин зі світу знаменитостей, страхів щодо громадського здоров’я та націоналістичної ностальгії. Такий контент часто виглядав аполітичним, однак приховано ніс політичні посили. Загалом матеріали суттєво відхилялися від реальної новинної повістки. Інші релевантні набори даних, зокрема Martinescu et al. (2024), будуть додатково досліджені в рамках проєкту PROMPT.

Meta визначає скоординовану неавтентичну поведінку (СНП) як кампанії, що маніпулюють публічними дискусіями на різних платформах (Meta, n.d.). Класичним інструментом СНП є астротурфінг — симуляція масової народної підтримки з боку організованих груп або приватних інтересів (Chan, 2022). Як зазначає Чан, це «проблема, що виходить за межі дезінформації» та створює зростаючі ризики для демократичної стійкості.

Румунський приклад ілюструє, як алгоритмічне таргетування, емоційні апеляції та скоординоване поширення контенту можуть викривлювати публічний дискурс і підривати виборчі процеси.

Докази скоординованої фейкової активності у румунських мережах Facebook під час виборів 2025 року

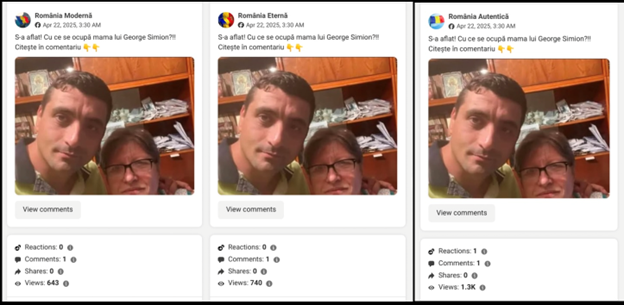

У межах президентських виборів 2025 року в Румунії мережевий аналіз 1489 публікацій у Facebook, проведений дослідниками проєкту PROMPT, виявив характерні ознаки скоординованої неавтентичної поведінки (CIB). Ці матеріали поширювались із 21 різного облікового запису, частина яких демонструвала чіткі ознаки пов’язаних вузлів — термін з аналізу мереж, що означає облікові записи, об’єднані синхронізованою активністю або ідентичним контентом. Яскравим прикладом стали сторінки România Eternă, România Modernă та România Autentică, які публікували в середньому по 149 постів упродовж надзвичайно короткого інтервалу — 9,3 секунди — протягом досліджуваного періоду. Така активність є типовою для автоматизованих систем або централізованого управління контентом.

Публікацію про лідера націоналістичної AUR Джорджа Сіміона та його матір поширили три акаунти протягом кількох секунд. Джерело: Meta Library, Prompt Research, 2025

Водночас характер публікацій вказує на спробу маніпуляцій емоціями — зокрема через зображення дітей, літніх людей чи дорослих, які стоять на самоті в сільських дворах із іменинними тортами, що викликають почуття жалю та суму, підкреслюючи наративи розірваних родин. ДіРеста та Гольдштейн (2024) описують подібні методи, коли спамери чи шахраї використовують згенеровані штучним інтелектом зображення у Facebook для розширення охоплення аудиторії.

Типовим прикладом є дописи без позначки про ШІ-генерацію, із підписами на кшталт: «Це мій перший торт! Буду радий вашим коментарям» або «Зроблено власноруч», які спонукають до коментування та взаємодії. Мета таких дописів подвійна: збільшення охоплення та вбудовування дезінформаційних меседжів у політичний дискурс.

За офіційною статистикою, Румунія має найбільшу діаспору в Європі — 5,7 мільйона осіб (Pop, 2025). Деякі публікації у виборчий період також активно експлуатували клікбейтні техніки: шокуючі новини про аварії, пожежі, смерті, стихійні лиха з посиланнями на сайт romaniacultural.eu, які запускали спливаючі антивірусні попередження про фішингові загрози. У політично напружені періоди контент на цих сторінках був переважно спрямований на просування політичних меседжів — зокрема схвальних згадок про Джорджа Сіміона та Дональда Трампа, а також публікацій із «передбаченнями» астрологів щодо результатів виборів.

Для ілюстрації масштабу: România Eternă має 116 000 вподобань та 116 000 підписників, România Autentică — 133 000 вподобань та 132 000 підписників, тоді як România Modernă має 115 000 підписників, але відсутність відображених вподобань — ще одна нетипова ознака, що може свідчити про аномальну або неприродну активність акаунту.

Публікацію про лідера націоналістичної AUR Джорджа Сіміона та його матір поширили три акаунти протягом кількох секунд. Джерело: Meta Library, Prompt Research, 2025

Якісний аналіз контенту

Аналіз контенту показав, що акаунти дотримувалися схожих естетичних та наративних стратегій. Більшість дописів містили емоційно навантажені сцени — зображення дітей, людей похилого віку чи ізольованих громадян, які святкують дні народження на самоті. Такі візуальні меседжі були орієнтовані на широку аудиторію та розраховані на виклик співчуття.

Однак у дні, що передували виборам 4 травня, відбулося різке тематичне зміщення — контент із загальнокультурного та емоційного став відверто політизованим. З’явилися дописи із похвалою міжнародних постатей на кшталт Дональда Трампа та Ілона Маска, а також матеріали щодо призупинення участі Румунії у програмі безвізового режиму США — рішення, оголошеного незадовго до виборів. Значну частину контенту складали про-Георгеску наративи та антиєвропейські теми.

Ця різка зміна тематики, поєднана з синхронізованим таймингом публікацій, свідчить про стратегічну спробу вплинути на виборчу поведінку румунських громадян наприкінці кампанії.

Згідно з аналізом дослідницької групи Університету Урбіно в рамках проєкту PROMPT, виявлені матеріали мали «виразну правопопулістську та націоналістичну спрямованість, особливо у висвітленні політичних акторів». Основні меседжі були спрямовані проти партій правлячої коаліції — соціал-демократів та лібералів — а також проти тодішнього президента Клауса Йоганніса (грудень 2014 – лютий 2025). Натомість інші пости відкрито підтримували AUR (Альянс за Союз Румунів) та його лідера Джордже Сіміона, євроскептичні наративи та ширший антиелітний популістський дискурс.

Водночас навіть дописи, що на перший погляд виглядали аполітичними (про особисті історії, здоров’я, ностальгію за минулим), містили приховані або завуальовані політичні посили. Наприклад, пости проти Соціал-демократичної партії (СДП) містили формулювання: «СДП повернулася до того, що вміє найкраще — давати порожні обіцянки і знущатися з народу», або «Злодії СДП знищили Румунію. Досить голосувати за червону мафію!», що демонструє яскраво виражені анти-СДП настрої на користь правонаціоналістичних сил та симпатиків AUR.

Окремі публікації напряму підтримували AUR і Джордже Сіміона: «AUR — єдиний голос правди! Всі інші партії в одній упряжці!» або «Джордже Сіміон нікого не боїться! AUR бореться за румунів!».

Критичні повідомлення також спрямовувалися проти президента Йоганніса — через його приналежність до Націонал-ліберальної партії (НЛП) він часто ставав мішенню антиістеблішментської, популістської риторики, яка виходила за межі традиційного ліво-правого поділу.

Поєднання такого контенту з емоційними, на перший погляд аполітичними темами (особисті трагедії, страхи за здоров’я, ностальгія за «втраченими цінностями») створило медіаекосистему, що сприяла просуванню популістських і крайніх наративів — передусім з боку ультраправого політичного спектра.

Скоординована неавтентична поведінка

У рішенні Конституційного суду Румунії координована неавтентична поведінка (CIB) та астротурфінг були названі ключовими причинами анулювання президентських виборів листопада 2024 року. Ці ж явища знову проявилися під час виборчої кампанії 2025 року. В країні налічується близько 9 мільйонів користувачів TikTok та понад 13 мільйонів користувачів Facebook.

У квітні 2025 року платформа TikTok деактивувала дві великі мережі фейкових акаунтів, спрямованих на маніпулювання політичними наративами у контексті виборів. Перша мережа складалася з 27 фейкових профілів із сукупною аудиторією понад 9000 підписників; ці акаунти видавали себе за новинні медіа, використовуючи псевдоніми та типові для медіа аватари для поширення певних повідомлень та впливу на публічні дебати (Ardelean, 2025). Друга мережа включала 4453 фейкових акаунти, які головним чином просували партію «Альянс за Союз Румунів» (AUR) та, меншою мірою, незалежного кандидата Келіна Джорджеску. Вона діяла з території Туреччини, використовуючи вигаданих осіб для поширення коментарів до румунських виборчих постів, а не для створення відеоконтенту. Середня кількість підписників кожного такого акаунта становила три. Розслідування TikTok встановило, що ця діяльність здійснювалася стороннім постачальником платних послуг із фальшивої взаємодії, однак особи та місцезнаходження організаторів залишилися невідомими (Ardelean, 2025).

Після виборів румунські та європейські регулятори розпочали офіційне розслідування. Згідно зі звітом TikTok від 7 січня 2025 року, платформа ідентифікувала близько 27 000 акаунтів, якими управляли з Туреччини. Кожен з них публікував по два-три кліпи на підтримку AUR та Келіна Джорджеску (станом на 17 грудня).

«Пам’ятаєте ботів, які генерували десятки тисяч коментарів на секунду, просуваючи потрібні пости?» — риторично запитав Крістіан Тергеш, кандидат у президенти та депутат Європарламенту, обраний за списком AUR (раніше — PSD, нині — екс-AUR). Він публічно звинуватив румунську владу у тому, що вона не визнала масштаби маніпуляцій, спрямованих як проти Келіна Джорджеску, так і проти самої партії AUR, та не вжила жодних правових заходів для їхнього припинення (Terheș, 2025).

Використання емодзі в алгоритмічних маніпуляціях

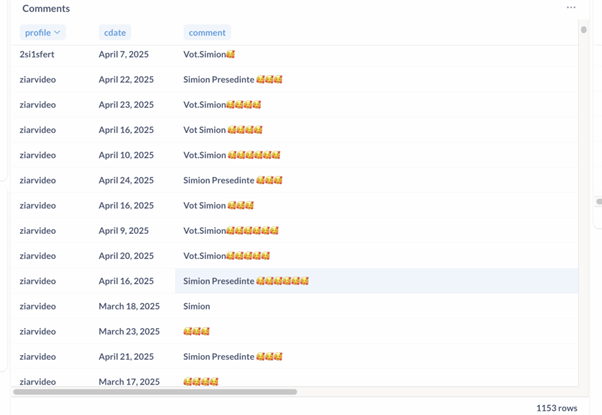

Особливо показовий випадок алгоритмічної маніпуляції став очевидним лише за два дні до президентських виборів у Румунії 4 травня 2025 року завдяки спільному розслідуванню журналістів-розслідувачів із видання Context та їхньої команди фахівців з комп’ютерних наук.

Знімок екрана з Context, 30 квітня 2025 року

Тімофте та Біро (2025) наводять емпіричні докази того, що маніпулювання алгоритмами рейтингування контенту на TikTok під час виборів виходило за межі традиційних технік на кшталт масових публікацій, спаму коментарів чи хештегів.

Дослідники встановили, що емодзі систематично використовувались для підвищення показників залученості (engagement) та видимості певних кандидатів.

Використовуючи спеціалізоване програмне забезпечення, команда проаналізувала 519 акаунтів TikTok, понад 70 000 публікацій, понад 4 мільйони коментарів і тисячі відео. Виявлені патерни свідчили про ймовірно автоматизовану або скоординовану діяльність.

Центральним прикладом став контент на підтримку Джордже Сіміона (AUR), де спостерігалося навмисне інтенсивне використання емодзі (наприклад, «🥰Simion Președinte🥰🥰🥰🥰»). Подібна стратегія застосовувалася також у публікаціях на підтримку інших кандидатів: Кріна Антонеску (🙏🌹), Марселя Чолаку (🌹🌹🌹), Віктора Понти (💯✌️) та Олени Ласконі (💙💙💙) (Timofte & Biro, там само).

Розслідування також показало перехід аудиторії від Келіна Джорджеску до Сіміона: кількість підписників останнього подвоїлася до 1,3 мільйона протягом лише 30 днів. Водночас акаунти, які раніше просували Джорджеску, залишалися активними, поширюючи контент на підтримку Сіміона через скоординовані коментарі та публікації.

Цей випадок демонструє, як ультраправі рухи можуть перепрофілювати вже існуючі цифрові мережі впливу та маніпулювати алгоритмами соціальних платформ для збереження своєї видимості навіть після офіційних дискваліфікацій кандидатів. До моменту проведення виборів (перенесених на травень 2025 року) масштаби таких маніпуляцій лише зросли: близько 15% з 400 000 останніх коментарів під контентом Сіміона все ще містили згадки про Джорджеску (Timofte & Biro, там само).

Дослідження також виявило міжпартійні зв’язки: частина ультраправих кандидатів, як повідомляється, залучала консультантів із середовищ центристських чи ліберальних політичних фігур (Neag et al., 2024), що розмивало ідеологічні кордони задля досягнення тактичних цифрових переваг. Загалом цей випадок свідчить про те, як навіть на перший погляд дрібні елементи — зокрема емодзі — можуть суттєво впливати на алгоритмічне ранжування контенту. Це підкреслює нагальну потребу у більшій прозорості соціальних платформ та посиленому судово-медичному моніторингу для запобігання маніпуляціям, що спотворюють публічний дискурс.

Онлайн-параметри CIB та зв’язок із FIDI

У низці звітів досліджувався феномен скоординованої неавтентичної поведінки (CIB) із застосуванням різноманітних методологій. Деякі свідчення з’явилися ще до анулювання виборів, зокрема у звітах Експертного форуму та розслідувальних медіа, тоді як інші — вже після офіційного скасування результатів виборів.

У спробі проаналізувати стрімке зростання популярності Келіна Джорджеску у соціальних мережах, французька служба спостереження за іноземним цифровим впливом (FIDI, SGDSN) у своєму лютневому звіті 2025 року виявила складну схему маніпулювання алгоритмами TikTok. У документі йдеться про «розгалужену кампанію маніпуляцій алгоритмом TikTok», яка охоплювала мережу взаємопов’язаних акаунтів та спеціально підібраний контент.

Французькі аналітики зазначають:

«Складна кампанія астротерфінгу включала цілеспрямовану маніпуляцію алгоритмом рекомендацій TikTok шляхом масового поширення відео та коментарів із заздалегідь визначеними хештегами та ключовими словами» (SGDSN, там само).

Реакція російських спецслужб на підтримку Джорджеску

Келін Джорджеску став першим кандидатом у посткомуністичній Румунії, щодо якого російська Служба зовнішньої розвідки (СЗР) публічно висловила позицію. У своїй заяві СЗР звинуватила Європейську Комісію в причетності до «рішення румунської прокуратури висунути звинувачення проти Джорджеску» («Известия», 2025). Водночас Служба боротьби з дезінформацією ЄС (EUvsDisinfo) не знайшла жодних підтверджень цим твердженням, назвавши їх конспірологічними теоріями («EuVsDisinfo», 2025).

Після анулювання результатів виборів румунські прокурори висунули Джорджеску обвинувачення за шістьма статтями, серед яких — спроба підбурювання до дій проти конституційного ладу та змова з метою дестабілізації країни. На підставі цих звинувачень йому тимчасово заборонили виїзд за кордон і участь у президентських перегонах.

Як зазначає Раду (2024),

«Риторика Келіна Джорджеску, що поширюється у соцмережах та на відеоплатформах, містить виразні проросійські, антинатовські та антиєвропейські наративи, доповнені численними посиланнями на релігію, псевдонауку, а також ідеї суверенного розвитку сільського господарства й економіки».

Механізми, що зробили Келіна Джорджеску помітною фігурою в онлайн-просторі, не були новими для аналітиків. Ще до виборів 24 листопада 2024 року аналітичний центр «Експертний форум» попереджав про потенційні маніпуляції, зокрема про кампанію під хештегом #balanceandverticality у TikTok. Влада, однак, істотно на ці застереження не відреагувала (Войня, МЕ, Іоніца, 18 листопада 2024 р.).

За два місяці до виборів контент із цим хештегом зібрав понад 2,4 мільйона переглядів, навіть попри відсутність офіційного бюджету на кампанію Джорджеску. Крім цього, використовувалися й інші інструменти: мережі фейкових акаунтів (27 000 із яких TikTok ідентифікував як керовані з території Туреччини) та система мікроплатежів незалежним блогерам, здійснюваних через агентство Fade Up. Це агентство згадувалося в розсекречених матеріалах румунської розвідки, а також стало об’єктом журналістського розслідування Le Monde (2024).

«Як і під час молдовської кампанії на підтримку Стояногло, румунські інфлюенсери, які раніше уникали політичних тем і спеціалізувалися на моді, макіяжі чи розвагах, допомогли змістити фокус публіки з кампанії Ліберальної партії, не згадуючи ім’я Джорджеску безпосередньо», — зазначає «Експертний форум» (2024). У період із вересня до кінця 2024 року хештег #calingeorgescu охопив 120 мільйонів підписників, що свідчить про масштабну кампанію впливу.

Стратегія TikTok для просування Джорджеску нагадувала раніше виявлені операції з мікроінфлюенсерами — такі як російська кампанія «Брат біля брата» в Україні (розсекречений звіт МВС, 2024) та кампанія за Стояногло в Молдові (Cristea, 2024; Expert Forum, 2024).

Рекомендації «Експертного форуму»

Окрім первинного попередження про маніпулятивні онлайн-кампанії, аналітики «Експертного форуму» також визначили ключові причини проблеми та надали низку рекомендацій для подальших дій:

– Забезпечити публічний доступ до даних, переданих до TikTok відповідно до вимог Європейської Комісії щодо збереження інформації. Зараз така інформація недоступна для незалежних дослідників, що створює загрозу для прозорості та об’єктивності аналізу.

– Усунути залежність від внутрішніх розслідувань TikTok, які залишаються закритими для зовнішніх експертів. Такий підхід підриває довіру до платформи та суперечить базовим принципам прозорості й підзвітності — особливо у періоди політичної напруги, таких як вибори.

– Провести незалежне дослідження алгоритмів рекомендацій TikTok, зокрема практики так званої «системи підігріву» (heating system) — ручного підвищення видимості певного контенту співробітниками компанії, що здатне суттєво впливати на інформаційне середовище.

(Джерело: Експертний форум, 2025)

Цей текст було вперше опубліковано на німецькому сайті EJO 27 травня 2025 року. Українською переклала Олександра Ярошенко.

Погляди, висловлені на цьому сайті належать авторам і не обов’язково відображають точки зору, політики та позиції EJO.

Tags: PROMPT, вибори, дезінформація, демократія, медіа і вибори, російська дезінформація, Румунія, румунські медіа