З початку повномасштабного вторгнення в Україну в лютому 2022 року Росія продовжує докладати зусиль у різних сферах, щоб атакувати та послабити Україну, в тому числі в інформаційному просторі. Арсенал російських тактик і методів залишається різноманітним — від фальсифікованих відео до операцій під чужим прапором — але водночас розвивається поруч з розвитком технологій.

Разом з тим, штучний інтелект та його практичні застосування, як то чат-боти, які генерують текст, або ж дифузійні моделі, які застосовуються для генерації зображень, стали доступні усім поза звичною групою дослідників й дослідниць в приватних компаніях та провідних університетах. З усіма позитивними сторонами, генеративний штучний інтелект (generative AI), був взятий на озброєння дезінформаторами для пришвидшення своєї роботи.

Хоч ШІ (поки що) не перевершив традиційні способи створення та поширення дезінформації, у цій статті, я розгляну реальні застосування штучного інтелекту в інформаційних операціях Кремля у тексті, аудіо та відео контенті, а також автоматизації, щоб продемонструвати сфери, де ці інструменти вже використовуються державою-агресором.

Відео

Використання штучно змінених відео розпочалось майже одразу після вторгнення, коли 16 березня 2022 року, російські джерела зламали сайт українського медіа та завантажили неякісно зроблений фейк про президента України Володимира Зеленського. У відео фейкова версія Зеленського стверджувала, що він подав у відставку, втік з Києва та закликав Збройні сили України здатися і врятувати свої життя. Абсолютно низька якість відео чітко вказувала на те, що це був діпфейк, де обличчя президента наклали на його тіло. Тому навіть прокремлівські джерела в Telegram почали називати його фейком, одночасно вихваляючись тим, що відео все ж «спромоглось змусити деяких українських військових здатися в полон».

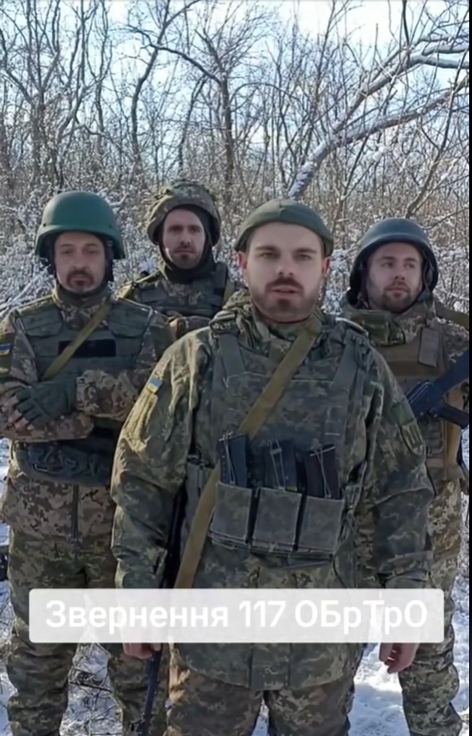

Проте, технології рухаються вперед, покращуючи якість відео підробок. Так, наприклад, російські Telegram-канали поширювати TikTok відео нібито військових зі 117 ОБрТрО [Окрема Бригада Територіальної Оборони, — редактор] із закликом до українського генерала Валерія Залужного усунути чинну владу. Згодом бригада відкинула правдивість відео й опублікувала заяву, в якій стверджувалося, що люди, зображені на відео, ніколи не були частиною бригади. Центр Протидії Дезінформації припустив, що відео було створено з використанням технології глибокого фейку.

Приклад застосування маніпуляції відео з накладенням масок (TikTok)

Окремим прикладом використання одразу відео й аудіо маніпуляції є lip-syncing (синхронізація губ), тобто метод, коли клонується голос людини й змінюється лише нижня частина обличчя, щоб відповідати словам, які вкладають у вуста спікера. Одним з яскравих прикладів такої кампанії була підробка виступу Олексія Данилова, колишнього секретаря Ради Національної Безпеки та Оборони. Так, низка російських пропагандистів опублікували інтерв’ю Данілова, де він начебто бере відповідальність за терористичний акт у Крокус сіті холі й обіцяє більше «таких веселощів» росіянам. Проте, Данілов не давав інтерв’ю телемарафону в день атаки й ніколи не казав цих слів, його міміка не зовсім збігається зі словами, а саме сфабриковане відео було створене з 2 різних відео — інтерв’ю Кирило Буданова й Данілова різним медіа.

В іншому випадку з’явилося відео, на якому чоловік під арештом зізнається, що українська розвідка наказала йому вбити американського ультраправого медіадіяча Такера Карлсона під час візиту до Москви в лютому 2024 року. Пізніше у звіті «Polygraf» було визначено, що людина, голос якої чути на відео, має ознаки «цифрової маніпуляції». Ба більше, його міміка також не збігається зі словами, які він говорить.

Використання відео хоч і є досить поширеним явищем, технології все ж не є досконалими й схожі дезінформаційні повідомлення дуже швидко спростовуються фактчекерами.

Аудіо

Використання аудіо стає більш поширеним й діє на кількох рівнях. По-перше, це клонування голосу для генерації слів, які людина говорить. Ця технологія має позитивне використання, як, наприклад, генерація голосів акторів, які померли, для нових ролей і камео. Як у випадку українського стартапу Respeecher, який повернув до життя для нової ролі голос актора Джеймса Джонса, який озвучував Дарта Вейдера у Зоряних війнах.

Проте, держава-агресор використовує схожі технології для своїх цілей. Так, одного разу було використано підроблене аудіо губернатора Техасу Грега Еббота, взяте з інтерв’ю Fox News про імміграційну політику США. Російські джерела опублікували змінену версію інтерв’ю в Telegram, з фальшивим голосом губернатора, коли відеозапис обрізали, щоб показати додаткові кадри, так званий b-roll, коли спікер не знаходиться у кадрі. У фальшивому аудіозаписі стверджується, що колишній президент США Джо Байден повинен повчитися у президента Росії Володимира Путіна, «як працювати на користь національних інтересів». В оригінальному інтерв’ю губернатор не згадував ні Путіна, ні Байдена, що підтвердили представники Fox News і офісу губернатора.

Інша сторона медалі, це озвучення відео за допомогою синтетичного аудіо голосу, щоб приховати акцент або національність виробника відео. Зокрема, ця тактика використовувалась в тому, що пізніше було визнано найбільшою операцією впливу, викритою в TikTok, в якій DFRLab та BBC Verify спільно розслідували тисячі пропагандистських відео сімома мовами, що звинувачували українське керівництво в корупції. Тобто, пропагандисти підготували текст, який озвучив штучний інтелект з нейтральним акцентом, приховуючи походження кампанії. Це аудіо було накладено на набір картинок, які нібито «доводили» надбання посадових осіб дозволило їхнім російським виробникам уникнути миттєвої детекції.

Текст

Одним із найочевидніших випадків використання є переклад. Хоча на початку вторгнення письмова російська дезінформація в Україні зазвичай висміювалася через граматичні помилки, пізніше якість текстів значно покращилася. Наприклад, кампанія «Doppelganger» просувала негативні історії про Україну з недосконалими, але правдоподібними перекладами, які мали кращий вигляд, ніж попередні зусилля. За даними Recorded Future, генеративний ШІ використовувався для створення статей для англомовних вебсайтів, пов’язаних з кампанією Doppelganger, таких як Electionwatch.info, тобто оригінальні новини з сайтів переписував ШІ із заздалегідь визначеним упередженням чи нахилом. Також, великі мовні моделі використовуються для генерації коментарів. Так, у звіті OpenAI є приклад, як спеціалісти компанії помітили та зупинили використання їхньої моделі в інформаційній кампанії з генерації коментарів для соціальних мереж.

Не напряму повʼязаною з генерацією тексту є проблема забруднення великих мовних моделей, які навчаються на текстах з інтернету. Так, дослідження NewsGuard демонструє, що великі мовні моделі можуть посилатись на російські або проросійські дезінформаційні видання, коли користувачі питають моделі та чат-боти вузькоспеціалізовані питання. Деякі дослідники це повʼязали з пропагандистською мережею Pravda, яка забруднює Вікіпедію, але проблема є ширшою, оскільки мовні моделі можуть збирати інформацію з й посилатись на російські державні медіа, які публікують сотні повідомлень на день, частина з яких є цитатами офіційних осіб та відвертими маніпуляціями та дезінформацією.

Автоматизація

Штучний інтелект використовується не тільки для генерації контенту, а й допомагає у розбудові інфраструктури для розповсюдження дезінформації через штучно створені облікові записи у соціальних мережах. Так, у липні 2024 року, Департамент Юстиції США оголосив про операцію запобігання роботи мережі штучностворених облікових записів, підсилених ШІ, які походили з РФ, щоб розповсюджувати пропаганду та дезінформацію у США. Так, згідно з документами відомства програмне забезпечення, яке використовували росіяни, містило частини ШІ, які генерували зображення та текст.

Таким чином, ШІ має багато можливостей для застосування у організації, підготовці й виконанні інформаційних операцій. Зловмисні актори використовують ШІ для створення облікових записів у соціальних мережах, переписують контент для своїх вебсайтів, генерують контент для коментарів, маніпулюють відео та аудіо матеріалами, щоб мати вплив на користувачів та поширювати неправдиву інформацію, недовіру та розпач. Проте, варто зазначити, що ШІ це всього лише інструмент, який використовується не тільки для поширення дезінформації, а й для детекції та протидії цим загрозам. Стартапи, як LetsData, використовують штучний інтелект для ранньої детекції інформаційних загроз, що дозволяє ефективніше їм протидіяти.

Погляди, висловлені на цьому сайті належать авторам і не обов’язково відображають точки зору, політики та позиції EJO.

Джерело зображення: Знімок екрана, TikTok.

Tags: Telegram, TikTok, глибинні фейки, російська пропаганда, Росія, фейки, чат-бот, ШІ, штучний інтелект